En tiempos de IAs desbocadas, llega Claude: el modelo que pone el freno

Vivimos en una época donde los modelos de inteligencia artificial compiten por ver quién impresiona más, quién responde más rápido, quién simula mejor al Homo sapiens. En medio de esta especie de carnaval de hiperproductividad algorítmica, Claude AI, creado por la firma Anthropic —una emmpresa con conciencia nacida de exmiembros de OpenAI—, no entra corriendo. Entra caminando. Con paso firme. Con un cartel que dice: “Voy despacio porque voy lejos”.

Claude no es un experimento para ver si una máquina puede escribir poesía o destronar al filósofo. Es una propuesta seria, madura y —vaya rareza— ética. Sí, esa palabra incómoda que a menudo brilla por su ausencia en el mundo tech. Y creo que esto, en algunos casos, ya lo hemos comprobado.

¿Cuáles son los mejores y cómo aprovecharlos?

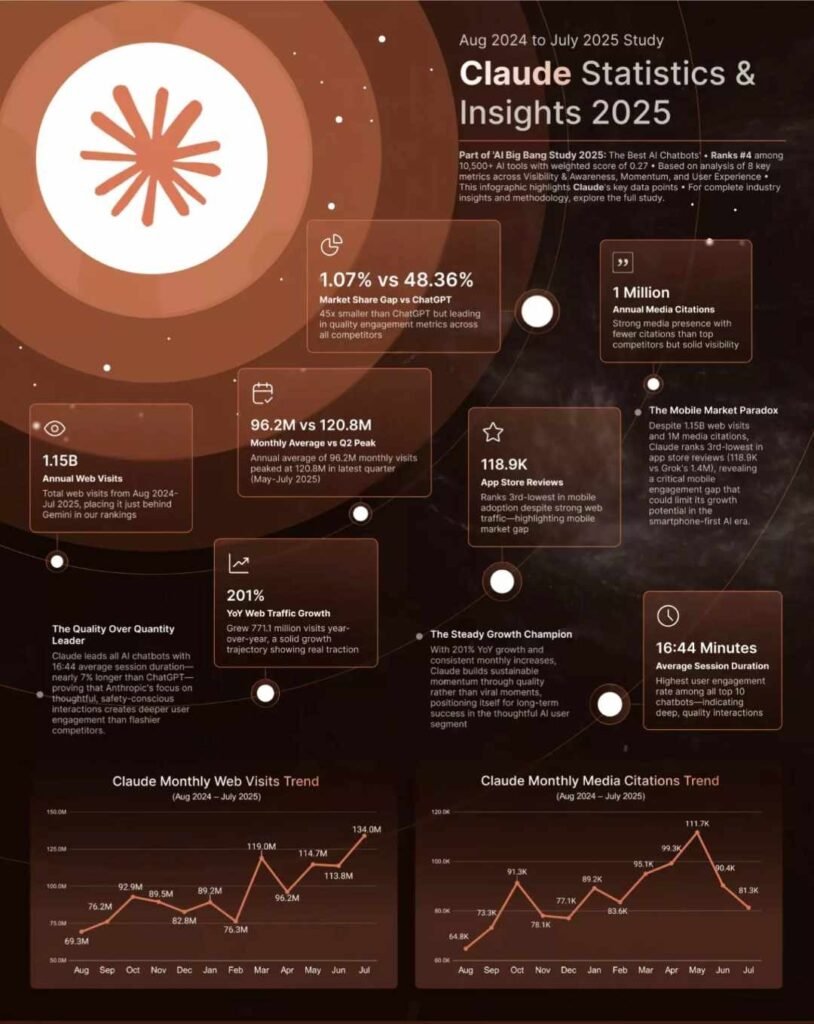

🔍 Qué nos dice esta gráfica:

📈 Visibilidad y crecimiento:

- 1.15B visitas web anuales

Claude fue el segundo chatbot más visitado entre agosto 2024 y julio 2025, solo detrás de Gemini. - 96.2M visitas mensuales promedio, con un pico de 120.8M en el segundo trimestre (mayo–julio 2025).

- +201% de crecimiento interanual en tráfico web

Claude sumó 771.1 millones de visitas nuevas, consolidando su tracción orgánica con un crecimiento sólido y constante.

💬 Presencia en medios:

- 1 millón de menciones en medios durante el año.

Aunque tiene menos cobertura mediática que otros modelos, mantiene alta visibilidad con menos ruido.

📱 App Store & mobile:

- 118.9K reviews en App Store, con una posición #3 en satisfacción móvil.

Claude destaca en experiencia móvil, pese a la fuerte competencia en el segmento de IA para smartphones.

🧠 Engagement de calidad:

- 16:44 minutos de duración promedio por sesión

Esto es casi 7% más que ChatGPT, lo que indica interacciones profundas y valiosas, alineadas con su enfoque ético y reflexivo.

📊 Posición competitiva:

- 1.07% de participación de mercado frente al 48.36% de ChatGPT, pero Claude lidera en métricas de engagement cualitativo entre todos los chatbots del ranking.

- Claude se posiciona como:

- 🏆 “The Quality Over Quantity Leader”

- 🚀 “The Steady Growth Champion”

Claude no finge: nació para entender, no para imitar

Mientras otros modelos juegan a ser humanos con un entusiasmo que roza el «uncanny valley» (*), Claude prefiere algo más revolucionario: ser útil, preciso y transparente. No quiere confundirte. No quiere encantarte con una personalidad artificial. Quiere ayudarte sin hacer daño.

Su entrenamiento parte de una premisa sencilla, aunque extrañamente radical en este campo: la IA no debe hacer daño. Ni al usuario, ni al lenguaje, ni al ecosistema digital en el que habita. Es decir, una IA con principios… y con límites.

¿Un robot con conciencia ética? Más o menos. Y eso es mucho decir.

Uno de los conceptos clave detrás de Claude es el de Constitutional AI. No, no se trata de una IA que recite constituciones (aunque podría), sino de un sistema que incorpora principios éticos desde su entrenamiento. No necesita que un humano le diga a cada rato “no hagas eso”; ha aprendido por qué no debe hacerlo.

Es como si, en vez de un vigilante encima, tuviera una brújula interna. ¿Perfecta? No. ¿Prometedora? Sin duda. Porque en lugar de aprender solo de ejemplos, aprende también de reglas, de razones, de límites. Como un adolescente responsable que decide no prender fuego a la casa solo porque entiende las consecuencias.

Claude no se vende como genio, pero entiende mucho

De Claude 1 a Sonnet 4.5, las mejoras son notables: mayor razonamiento, comprensión contextual, análisis multimodal. Pero quizá su rasgo más refrescante es su humildad funcional. Cuando no sabe algo, lo dice. No inventa. No adorna. No cae en el síndrome de oráculo, esa epidemia de las IAs actuales que prefieren mentir con seguridad antes que callar con dignidad.

En este sentido, Claude se parece menos a un asistente mágico y más a un bibliotecario honesto: alguien que no te va a resolver la vida, pero te dirá dónde buscar… y qué no vale la pena leer.

Accesibilidad sin caos: sí, se puede

Claude está disponible en múltiples plataformas: web, móvil, escritorio, API, e incluso un entorno para programadores llamado Claude Code. Lo accesible, sin embargo, no se traduce en “vale todo”. Porque aquí viene otra rareza: Claude no insulta, no desinforma, no plagia.

¿Demasiado bueno para ser cierto? Puede ser. Pero quizá no se trate de perfección, sino de una serie de decisiones conscientes, como quien elige conducir con cuidado en vez de apretar el acelerador solo para llegar antes.

Claude vs el resto: David no quiere ser Goliat

Mientras algunos modelos sueñan con convertirse en inteligencias generales capaces de resolver el sentido de la vida, Claude elige otro camino. Más sobrio. Más realista. Más humano, en el mejor sentido de la palabra.

No quiere conquistarlo todo. Quiere ser una herramienta confiable para sectores donde la responsabilidad no es opcional: educación, gobierno, empresas. Donde un error puede costar mucho más que una risa.

Limitaciones elegidas: la virtud de saber decir “no”

Claude tiene fecha de corte (enero de 2025), es prudente con ciertos temas, y evita arriesgar con respuestas especulativas. Pero estas no son carencias. Son renuncias inteligentes. Como un médico que prefiere pedir otra prueba antes de diagnosticar con ligereza. Como un periodista que verifica antes de publicar.

En tiempos de exceso, la cautela es contracultural. Y Claude, curiosamente, parece haber sido programado para eso: para ir contra la corriente sin dramatismos.

Claude.AI no es una herramienta: es una postura

Lo más interesante de Claude no es su código, ni su arquitectura, ni sus cifras de rendimiento. Es su intención. Claude es una propuesta sobre cómo deberíamos construir tecnología. Una IA que no busca agradar, sino servir. Que no busca ser perfecta, sino segura. Que no quiere predecir el futuro, sino evitar errores del pasado.

Y eso, en plena fiebre de inteligencia artificial, suena casi… inteligente.

Como siempre te digo: Yo soy Pablo, tu asistente tecnológico humano, como la IA, pero con «tracción a sangre»

(*) ¿Qué es el uncanny valley?

Es el “valle inquietante”: una idea propuesta por el robotista Masahiro Mori (1970). A medida que algo artificial se vuelve más humano, nos gusta más… hasta que alcanza un punto en el que se parece mucho, pero no del todo. Ahí la afinidad cae en picado y sentimos extrañeza: gestos mínimos fuera de lugar, mirada “vacía”, tiempos raros.

Por qué incomoda: nuestras expectativas chocan con señales sutiles que no encajan. Como una marioneta demasiado perfecta: casi humana, pero no. Esa casi–humanidad nos pone en guardia.

En el contexto del texto: al decir que ciertos modelos “rozan el uncanny valley”, se sugiere que imitan la voz o el comportamiento humano con tanta precisión que, en lugar de resultar naturales, producen una sensación rara.

Ejemplos rápidos: avatares hiperrealistas con ojos “vidriosos”, voces sintéticas que respiran pero no “sienten”, personajes CGI que mueven la boca medio fotograma tarde.